Ce projet est un moteur d’adaptation audiovisuelle (dubbing) entièrement automatisé, développé avec Bun et TypeScript , qui permet de traduire des fichiers audio et vidéo. Il inclut plusieurs fonctionnalités avancées comme le clonage de voix , la génération de sous-titres , la séparation audio , la synchronisation labiale , ainsi que la traduction contextuelle intelligente . Ce moteur est à la base du service VoiceCheap.ai .

Fonctionnalités Principales

Le moteur propose une panoplie de fonctionnalités innovantes :

- Clonage et génération de voix : Reproduit les voix des personnes parlant dans la vidéo originale.

- Détection automatique de la langue : Identifie la langue source sans intervention manuelle.

- Adaptation vocale naturelle (SmartSync) : Ajuste la vitesse et la structure des phrases pour correspondre au timing original.

- Séparation audio de fond : Isole les voix principales du bruit de fond ou de la musique.

- Génération de sous-titres : Crée automatiquement des sous-titres synchronisés.

- Synchronisation des lèvres : Fait bouger les lèvres des personnages en phase avec les nouvelles voix.

- Support de 35 langues : Permet la traduction vers et depuis un large éventail de langues.

Méthodologie de Fonctionnement

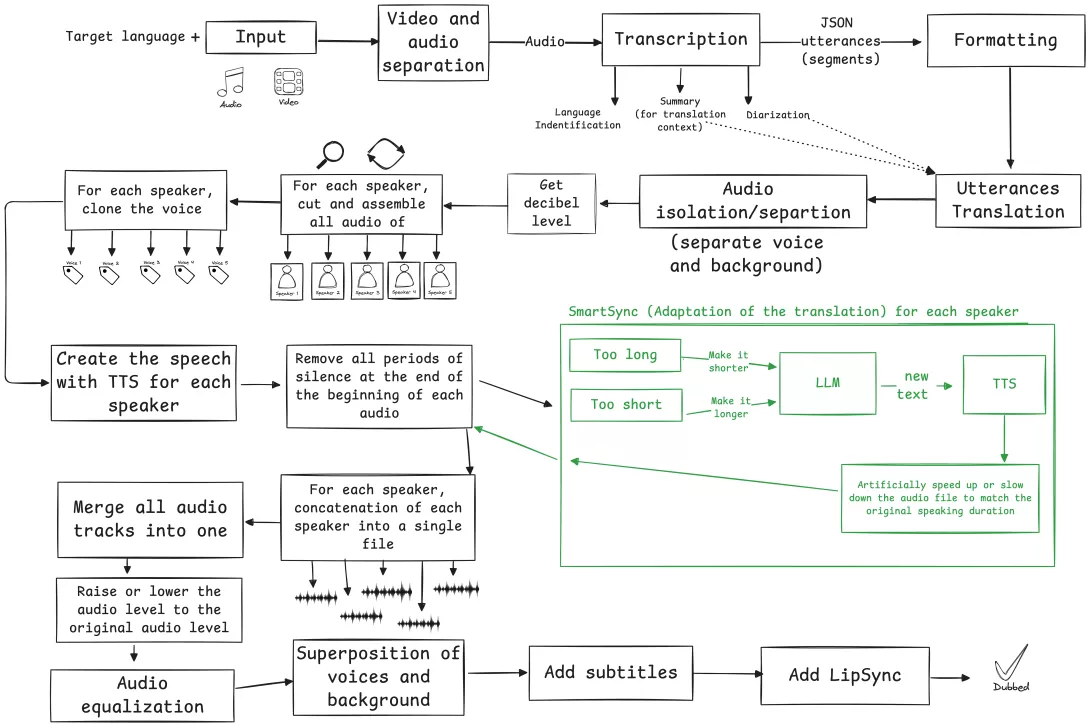

Le processus de dubbing suit un flux bien structuré en plusieurs étapes :

1. Configuration

L’utilisateur sélectionne la langue cible et active/désactive certaines options (ex. : sous-titres, lip-sync, etc.).

2. Transcription & Analyse

- Détection de la langue source.

- Transcription précise de l’audio.

- Résumé du contexte global.

- Diarisation des locuteurs (identification des différentes voix).

3. Traduction

- Segmentation du texte transcrit.

- Traduction assistée par un modèle de langage (LLM), tenant compte du contexte.

- Adaptation intelligente du texte pour respecter le timing original (SmartSync).

4. Traitement Audio

- Séparation des voix et de l’audio de fond.

- Mesure des niveaux sonores.

- Création d’une chronologie précise pour chaque locuteur.

5. Génération de Voix

- Clonage de chaque voix détectée.

- Application de SmartSync pour adapter la prononciation et le rythme.

- Ajustement de la vitesse si nécessaire.

6. Assemblage Final

- Concaténation des segments traduits.

- Équilibrage des volumes sonores.

- Fusion des nouvelles voix avec l’audio de fond.

- Ajout des sous-titres.

- Synchronisation des mouvements des lèvres.

SmartSync – L’Adaptation Intelligente

SmartSync est une technologie brevetée qui ajuste dynamiquement le contenu vocal généré pour qu’il corresponde au timing et au rythme du discours original . Quand la traduction littérale serait trop longue, SmartSync reformule intelligemment les phrases pour conserver un rendu naturel et synchronisé.

Comment Commencer ?

Prérequis Techniques

Avant de lancer le projet, vous devez installer :

- Node.js : Environnement d’exécution JavaScript.

- Bun : Runtime JS et outil de build ultra-rapide.

- FFmpeg : Outil de traitement multimédia.

- Clés API pour plusieurs services externes.